(Autor: Nuno Filipe da Silva Fernandes de Castro, LIP)

Descrição/ Objetivos Científicos:

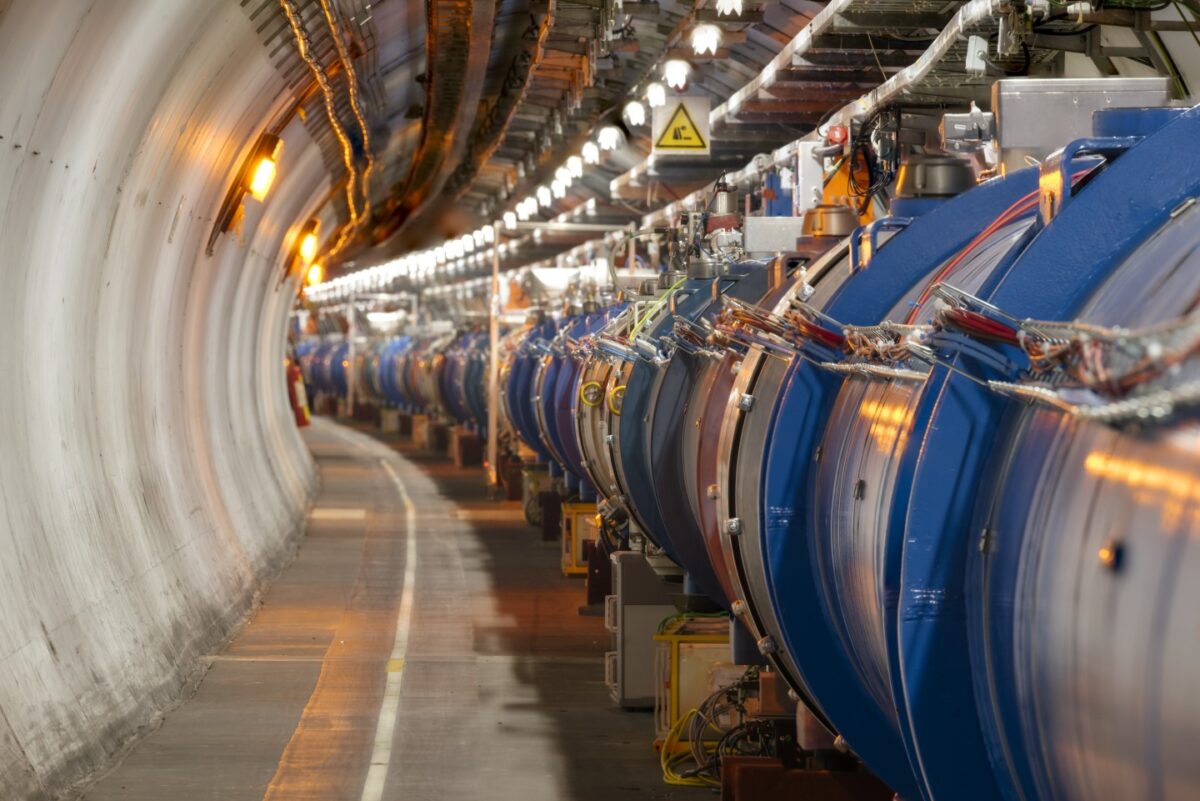

A Física de altas energias gera quantidades extraordinárias de dados complexos e a sua exploração total requer técnicas de análise igualmente complexas. O objetivo da atual proposta é o desenvolvimento de técnicas avançadas de machine learning para analisar os dados recolhidos pelas experiências do Large Hadron Collider (LHC) e por detetores que procuram interações de matéria escura. Para o efeito, amostras extensivas simuladas, descrevendo tanto os já conhecidos processos do modelo padrão, como novos processos de física, terão de ser geradas e simuladas utilizando métodos de Monte Carlo. Dada a elevada luminosidade esperada na próxima fase do LHC, centenas de milhões de eventos de colisões terão de ser simulados para que uma amostra representativa dos dados seja recolhida. Tais simulações, que requerem tempo de CPU significativo (da ordem das cem mil horas) e espaço em disco (da ordem de 10 Tb) a obter, serão usadas para treinar métodos de aprendizagem automática supervisionados e semi-supervisionados. Estes métodos, baseados em complexas redes neuronais profundas, contribuirão para avançar na exploração dos dados do LHC, onde Portugal tem uma forte presença. Em particular, isso contribuirá para melhorar a generalidade da pesquisa por novos fenómenos, garantindo que uma eventual descoberta não seja perdida apenas porque os detalhes dos processos de pesquisa não são conhecidos.

Requisitos Computacionais:

Este trabalho requer recursos computacionais de Alto Desempenho para análise de dados, 150 000 horas de CPU com 100 CPU e 15TB de espaço em disco, e GPU para estudos de Machine Learning (ML) (4 300 horas e 5TB de espaço em disco).

Este trabalho foi produzido com o apoio da INCD financiada pela FCT e FEDER através do projeto 01/SAICT/2016 nº 022153